Google Fotos, todos fodidos. Meu amigo não é um gorila.

Google "corrigiu" o seu algoritmo racista, removendo gorilas da tecnologia de marcação de imagem

Nearly three years after the company was called out, it hasn’t gone beyond a quick workaround

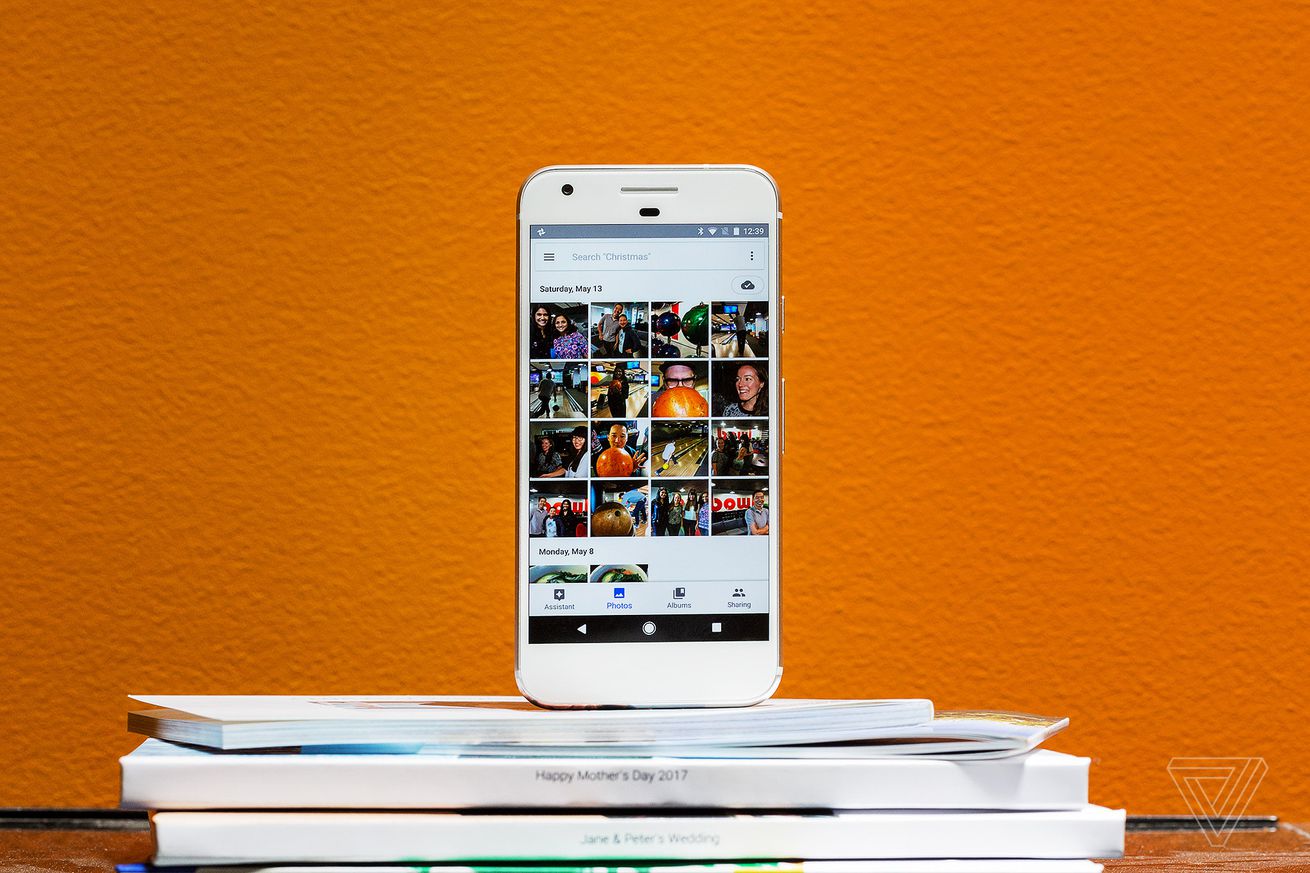

De volta em 2015, o engenheiro de software Jacky Alciné apontou que os algoritmos de reconhecimento de imagem no Google Photos classificavam seus amigos negros como “gorilas”. O Google disse que estava “consternado” com o erro, pediu desculpas a Alciné e prometeu resolver o problema. Mas, como um novo relatório dos shows da Wired , quase três anos e o Google não corrigiu nada. A empresa simplesmente bloqueou seus algoritmos de reconhecimento de imagem de identificar gorilas completamente – preferindo, presumivelmente, limitar o serviço ao invés de arriscar outra categorização incorreta.

Wired diz que realizou uma série de testes no algoritmo do Google Photos, carregando dezenas de milhares de imagens de vários primatas para o serviço. Babuínos, gibões e sagüis estavam todos corretamente identificados, mas gorilas e chimpanzés não eram. A publicação também descobriu que o Google restringiu o seu reconhecimento AI em outras categorias raciais. Procurando por “homem negro” ou “mulher negra”, por exemplo, apenas retornou fotos de pessoas em preto e branco, ordenadas por gênero, mas não de raça.

Um porta-voz do Google confirmou à Wired que as categorias de imagens “gorila”, “chimpanzé”, “chimpanzé” e “macaco” permaneceram bloqueadas no Google Fotos após o tweet da Alciné em 2015. “A tecnologia de rotulagem de imagem ainda é cedo e, infelizmente, está perto de perfeito “, disse o representante. As categorias ainda estão disponíveis em outros serviços do Google, no entanto, incluindo a Cloud Vision API que vende para outras empresas e o Assistente do Google.

Pode parecer estranho que a Google, uma empresa que geralmente é vista como o precursor da IA comercial, não conseguiu encontrar uma solução mais completa para este erro. Mas é uma boa lembrança de quão difícil pode ser para treinar o software AI para ser consistente e robusto. Especialmente (como se poderia imaginar que aconteceu no caso do erro Google Photos) quando esse software não foi treinado e testado por um grupo diversificado de pessoas.

Não é claro, neste caso, se o algoritmo Google Photos permanece restrito dessa maneira porque o Google não conseguiu solucionar o problema, não queria dedicar os recursos para fazê-lo, ou simplesmente mostra uma superabundância de cautela. Mas é claro que incidentes como este, que revelam a cultura do Vale do Silício, muitas vezes insular, que se encarregou de construir algoritmos de abrangência mundial, precisam de mais do que soluções rápidas.

Contact Information:

James Vincent

Tags:

, Wire, Artificial Intelligence Newswire, United States, Portuguese

Keywords: afds, afdsafds